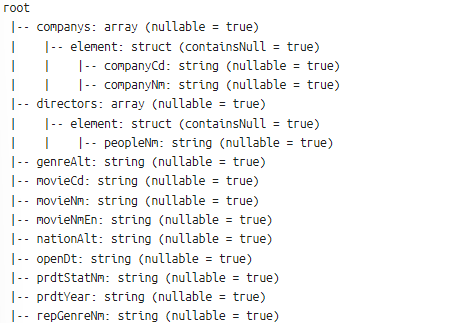

1. JSON 파일 불러오기%spark.pysparkimport osinput_path = os.path.expanduser('~/data/movbotdata/movieList.json')jdf = spark.read.option("multiline", "true").json(input_path)#jdf = spark.read.option("multiline","true").json('/home/odsummer/data/movbotdata/movieList.json') json파일 안에 데이터 형식 단일이 아닌 여러줄로 구성되어 있는 경우, multiline 값을 true로 주는 옵션을 줘야한다.2. JSON 파일 스키마 확인%spark.pysparkjdf.printSchema()root |-- comp..